Meituan(美団)のLongCatチームは、高速推論モデル「LongCat-Flash-Thinking」を正式公開した。従来のLongCat-Flash-Chatが持つ極限の速度を維持しつつ、論理・数学・コード・エージェントなど複数分野の推論タスクで世界最先端(SOTA)の性能を達成したと強調している。特にエージェントの自律的なツール利用や形式的な定理証明の能力を兼備する点で、中国で初めて「高度な推論とツール利用」「非形式的推論と形式的推論」を統合した大規模言語モデルと位置づけられる。

訓練面では、STEM・コード・エージェントの最適化を分離する「Domain-Parallel RL」方式を導入し、安定した強化学習を実現。さらに非同期・高効率の訓練基盤「DORA」により、従来比3倍の高速化を達成しつつ、KVキャッシュの再利用で大規模クラスタにも対応する。推論能力の強化では、二重経路の「エージェント推論フレームワーク」を通じて最適サンプルを選び外部ツールを統合、90%の精度を維持しながらトークン消費を64.5%削減するなど効率性を高めた。形式的な推論については、Lean4を用いた専門家反復フレームワークで合成データを生成し、証明過程の信頼性を高めている。

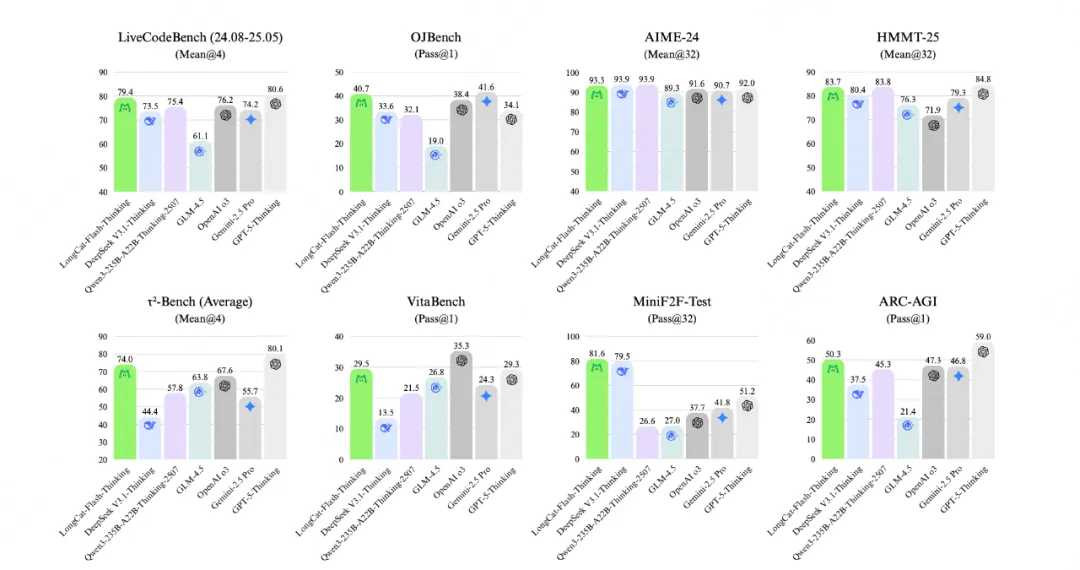

ベンチマークでは、ARC-AGIで50.3点を記録しOpenAI o3やGemini 2.5 Proを上回ったほか、数学分野でもAIMEやHMMTで突出した成果を示した。コード分野ではLiveCodeBenchで79.4点を獲得し、オープンソースモデル最高値を更新するとともにGPT-5に匹敵する性能を示した。エージェントタスクにおいてもτ2-BenchでSOTAを刷新し、形式的推論MiniF2F-testではpass@1で67.6点と大幅なリードを確保している。

同モデルはHuggingFaceおよびGitHubで全面的にオープンソース公開されており、研究者や開発者による応用展開が期待される。