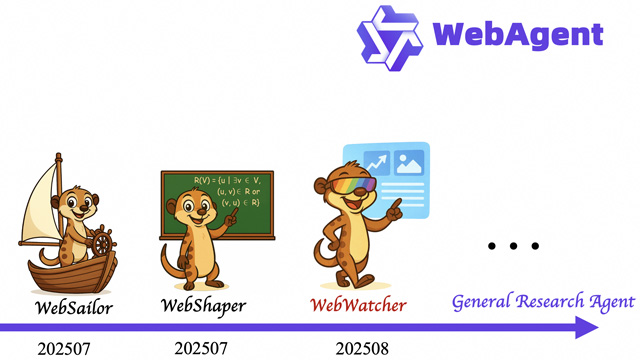

アリババのTongyi Labは、新たなオープンソース視覚エージェント「WebWatcher」を公開した。従来のテキスト中心のDeep Research型AIと異なり、画像や図表を含む複雑な情報を理解・統合しながら推論を行えるマルチモーダルエージェントである。WebWatcherはウェブブラウジング、画像検索、OCR、コード実行といった多様なツールを統合し、人間の研究者のように情報収集と検証を進める設計となっている。

Tongyi Labはまず、ランダムなウェブ探索と情報の意図的な曖昧化を取り入れた高難度データ生成プロセスを構築し、従来の単純なVQAを超える多段階推論課題を作成した。さらに、実際の多ツール操作に基づく高品質の推理軌跡を収集し、これを監督微調整(SFT)と強化学習(GRPO)に活用することで、WebWatcherに柔軟な推論能力と堅牢な意思決定を持たせた。

性能評価では、BrowseComp-VLをはじめとする複数のマルチモーダルベンチマークで顕著な成果を示した。特にBrowseComp-VLにおけるPass@1スコアは27.0%に達し、GPT-4o(13.4%)、Gemini2.5-flash(13.0%)、Qwen2.5-VL-72B(11.5%)、Claude-3.7(11.2%)などを大きく上回った。また複雑推論(HLE-VL)、マルチモーダル検索(MMSearch)、知識統合(LiveVQA)といった領域でも圧倒的な優位性を示し、既存のオープンソースおよび商用大規模モデルに対し新たな基準を打ち立てた。

WebWatcherはすでにGitHubで公開されており、Tongyi Labは研究者や開発者に対してマルチモーダルDeep Researchの可能性を共に探求することを呼びかけている。