テンセント混元が公開した「Hunyuan-A13B」は、業界初の13B規模ハイブリッド推論対応MoEモデル。80Bパラメータを持ちながら、推論時に必要なアクティブパラメータは13Bに抑えられており、高速かつ高性能な出力を実現している。実際のスループットは他の先端オープンモデルの2倍以上で、効率面で大きな優位を持つ。

モデルは最大256Kの長文処理に対応し、データ分析や旅行プラン作成などの複雑なタスクにおいても、検索・天気・ホテルなどのツールをエージェント的に呼び出して処理可能。ユーザーは「速思考」と「遅思考」モードを選択でき、速度重視か高精度重視かを柔軟に切り替えることができる。

中低スペックGPU1枚で動作可能という軽量性も特徴で、HuggingFaceやGitHubにてモデルが公開されている。推論フレームワークや量子化形式にも対応し、開発者への導入ハードルは低い。

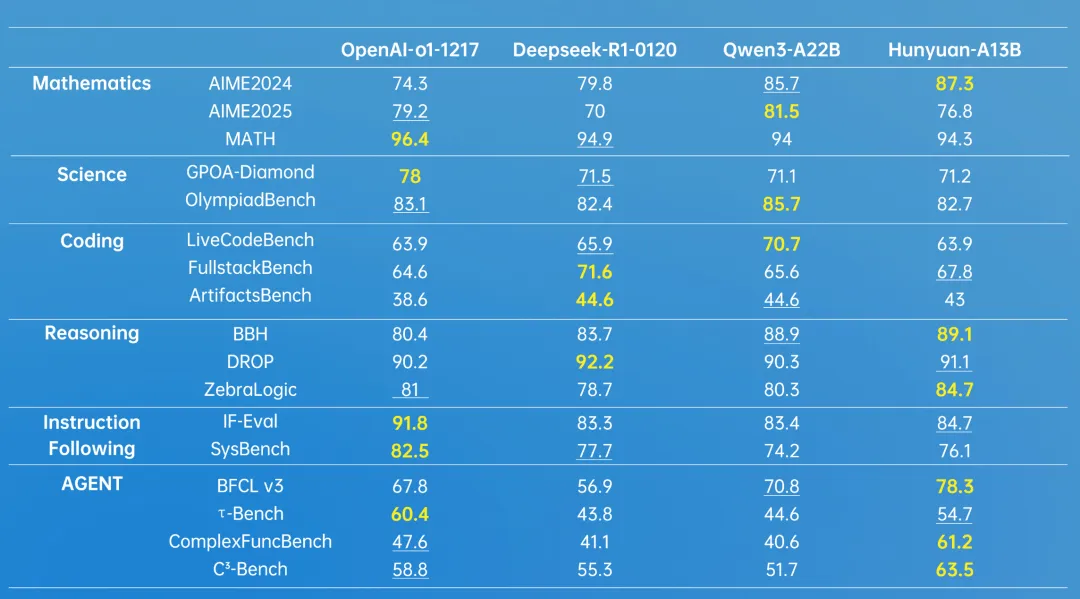

テンセントはこのモデルの訓練に20Tトークンの大規模高品質データを使用し、MoEに最適化されたScaling Lawを構築。さらに後訓練では創作・理解・推論・エージェント対応を強化した多段階トレーニングを実施。コード生成やUIタスクを評価する「ArtifactsBench」、エージェント処理を検証する「C3-Bench」も同時公開された。

Hunyuan-A13Bはすでに社内で400超の業務に導入され、1日あたり1.3億件以上のリクエストがある。今後は0.5B〜32B規模のMoEモデルを含む複数ラインナップを展開予定で、マルチモーダルな基盤モデルも順次オープンソース化される方針だ。