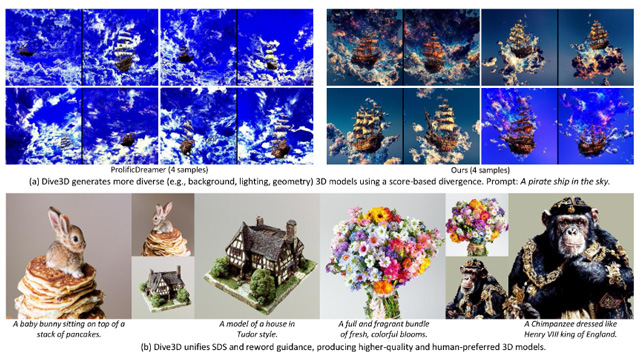

北京大学と小紅書の研究チームが発表した「Dive3D」は、テキストからの3D生成に新しい指針を示すモデルであり、KL散度に依存する従来手法の限界を打破すべく、スコアベースの「Score Implicit Matching(SIM)損失」を導入した。これにより生成結果の多様性が大きく向上し、同時に視覚品質やテキスト整合性も改善された。

Dive3Dは、拡散蒸留と報酬誘導最適化という異なる最適化手法を「発散最小化」という共通原理のもとに統一。これにより、複数の性能指標を一つのフレームで協調的に最適化できる点が特徴である。評価はGPT-Eval3Dベンチマークを用い、DreamFusionやMagic3Dなど既存9手法を上回る結果を記録。特にテキスト整合性(+53.5)やテクスチャ詳細(+67.5)など、6つのすべての評価項目で首位を獲得した。

実装はGitHub上でPyTorchコードとして公開されており、公式プロジェクトサイトでは実際に生成された3Dオブジェクトのデモも確認できる。2D画像生成やNeRFベースの3D合成においても、KL散度ベースの手法と比べ、背景・光照・スタイルの多様性が顕著に高いことが示されている。

現時点では各オブジェクト生成に約1時間を要するが、今後はSIM損失を多視点生成器や低ランク表現(LRM)と組み合わせ、リアルタイム性と多様性の両立を目指した進化が期待される。