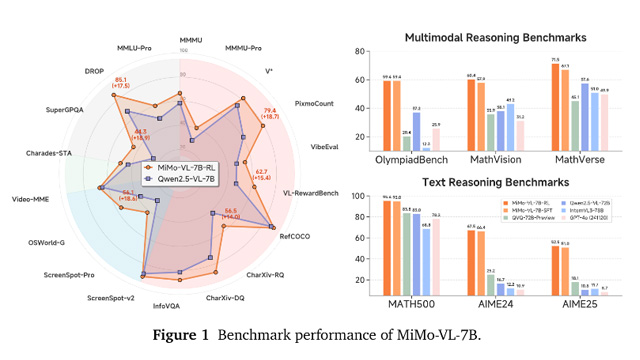

シャオミ(Xiaomi)は、最新の多モーダル大規模モデル「MiMo-VL-7B」を発表し、オープンソースとして公開した。7Bパラメータ規模ながら、AliのQwen2.5-VL-72BやGPT-4oといった大規模モデルを超える性能を実証。画像・動画・自然言語・GUI操作を統合処理する高い汎用性を持ち、エージェントAI時代の推論基盤として設計されている。

性能向上の鍵は、2.4Tトークンの多段階プレトレーニングデータと、独自のMORL(混合オンライン強化学習)にある。画像・テキスト・動画・GUI操作といった異種データを段階的に学習させ、推論精度と長距離依存理解を両立。さらにRLHFや人間フィードバックも取り入れ、ユーザー体験を高めている。

MiMo-VL-7Bは、50以上の推論ベンチマークを評価可能なオープンな評価フレームワークも提供。また、言語モデルMiMo-7Bの最新版(MiMo-7B-RL-0530)も同時に公開され、数学推論などの競技ベンチでDeepSeek R1やOpenAIモデルに肉薄する性能を記録した。

シャオミは、生成AIからエージェントAIへの時代に向け、MiMo-VLを中核技術として継続的なアップグレードを計画している。MiMo-VLはその第一歩に過ぎず、今後さらに強力な多モーダルエージェントモデルの登場が予想される。