アリババが発表した「LAM(Large Avatar Model)」は、仮想人間やAIアバターの表現に革新をもたらす新技術だ。1枚の画像をもとに、アニメーション可能な3Dガウス顔モデルを1回の推論で生成でき、従来必要とされた多視点学習や追加ネットワークを不要とする。

FLAMEの標準顔点群をベースに、Transformerによる学習可能なクエリを用いて画像から抽出した特徴と結合し、高精度なガウス属性を生成。さらにLBS(線形混合スキン)と補正BlendShapeにより、リアルタイムでの表情アニメーションが可能となっている。

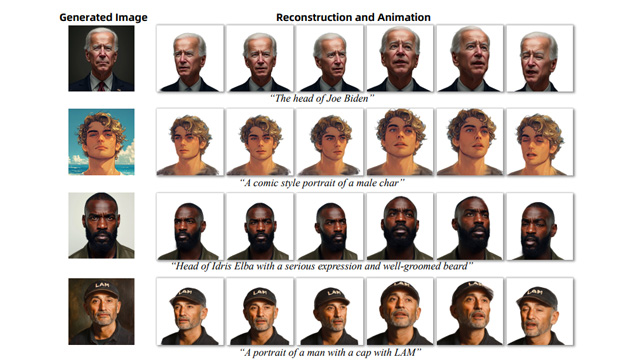

本モデルは2D画像の編集結果をそのまま3D空間に反映させることができ、テキストから画像を生成し、さらにその画像から3Dアバターを構築するAIGCワークフローもサポート。AIキャラクターやVTuberの制作現場にとって非常に応用性が高い。

実装はGitHub上でApache 2.0ライセンスにて公開されており、Hugging Face上では誰でもブラウザから動作確認ができる。学術研究にも、商業利用にも即応可能なアーキテクチャとして注目されている。