アリババ傘下のAI研究機関Tongyi Labが開発したVACE(Video Atomic Composable Editing)は、動画生成と編集機能を一体化したAIモデルであり、Wan(通義万相)シリーズの一環としてオープンソース公開された。480Pおよび720Pの解像度に対応し、文、画像、動画、マスク、ポーズや光流などの制御信号を統合的に扱う。

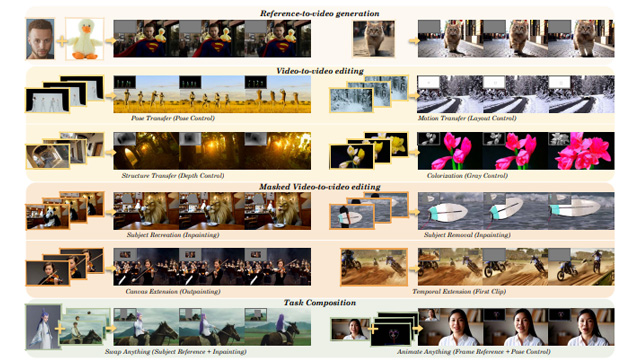

VACEは従来モデルでは複数ツールを必要としていた文生動画、画像参照生成、局所再描画、動画補完などの作業を、1モデルで処理可能にする。入力形式には「VCU(Video Condition Unit)」を採用し、フレーム列とマスク列に基づいて柔軟なタスク合成を実現。これにより、静止画からの動き生成や動画背景の動的な再構成も容易となる。

内部構造では、可変・不変フレームをVAEで符号化し、マスクは64chの空間特徴に変換。DiTに対応するトークン列として統合される。トレーニング戦略では、全体微調整と比較して基盤モデル能力を保持しつつ高速な収束を可能にする「コンテキストアダプター微調整」方式を採用した。

VACEのコードとモデルはGitHub上で公開されており、Hugging FaceやModelScopeからも取得可能。今後はWan公式サイトでも機能連携が進む予定。生成から編集まで対応可能な統合モデルとして、AI動画制作に新たな標準を打ち立てることが期待される。