清華大学の研究チームは、CVPR 2025にて動画から3Dシーンを一括で生成する革新的な拡散モデル「VideoScene」を発表した。本モデルは、既存のマルチステップ生成アプローチにおける処理の冗長性を排除し、推論効率と出力品質の両立を実現している。

VideoSceneの技術的核となるのは、「3D-aware leap flow distillation」と呼ばれる独自の蒸留戦略。これは従来の動画拡散モデルが抱える“無駄なノイズ除去ステップの多さ”という課題を、重要でないステップをスキップすることで克服する手法である。さらに、動的なノイズ除去ネットワーク(Dynamic Denoising Policy, DDP)により、推論中の最適なジャンプタイミングをリアルタイムで決定できる設計となっている。

具体的なパイプラインとしては、まず少数の視点画像からMVSplatベースの3D表現を生成し、精密なカメラ軌道制御によるレンダリングを行う。その後、レンダリングされた潜在表現と条件付き表現を一致させて拡散過程に投入し、教師モデルと学生モデルの蒸留学習により予測精度を高めていく構成だ。

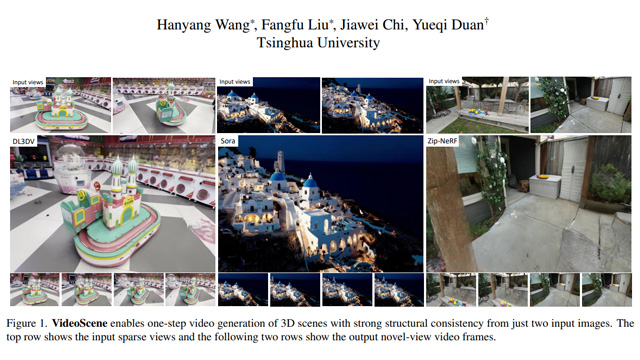

公式プロジェクトページに掲載されたデモ比較では、従来手法に見られるぼやけ・過剰な動き・物体位置のずれといった欠点が、VideoSceneによって大きく改善されており、生成された3Dシーンの時間的一貫性と空間的リアリズムが高く評価されている。

さらに、研究成果はすでにarXivで公開されており、GitHubにてコードがオープンソースとして提供されている。プロジェクトページでは視覚的なデモやアーキテクチャ解説が閲覧可能で、今後の応用や研究発展において高い再現性と拡張性が期待される。