中国AIスタートアップSand.AIは、全く新しい自回帰型動画生成モデル「Magi-1」を発表した。創業者の曹越(Cao Yue)は清華大学特別奨学金の受賞者であり、Swin Transformer開発の主要人物としても知られる人物。彼が率いるチームが生み出したこのモデルは、従来の拡散モデルでは困難だった“時間的連続性”と“物理的整合性”を両立する。

Magi-1は、Diffusion Transformerをベースにした自回帰フレームワークで、動画を24フレーム単位の「チャンク」として段階的に生成する。この設計により、前後の映像間での一貫性を保ちながら、任意の長さの連続動画を出力できる。また、動きの自然さを損なうことなく、1秒単位で再生時間を制御することも可能だ。

注目すべき点は、モデルアーキテクチャ、推論インフラ、訓練プロセスに関する情報をまとめた61ページの技術報告書と、すべてのコード・モデルが完全オープンソースでGitHub上に公開されていること。高性能GPUがなくとも、NVIDIA RTX 4090一枚で4.5Bモデルが動作するよう最適化されており、実用性も非常に高い。

注意機構には、Block-Causal Attention、3D RoPE位置エンコーディング、Parallel Attention Block、QK-Norm、GQAなどの先進手法が組み込まれ、映像内の時空間的関係を高精度で処理。推論フェーズでは、FlashAttentionベースの独自実装「Flex-Flash-Attention」により、計算効率とマスク適用の柔軟性を両立している。

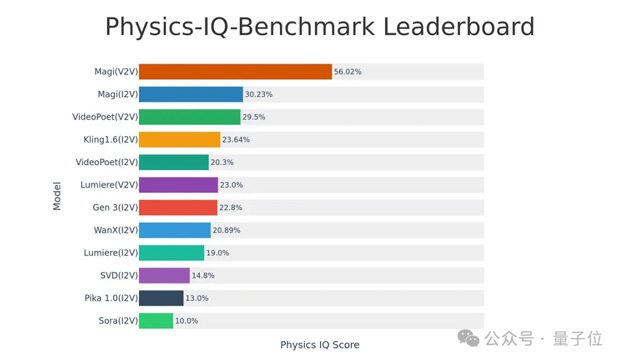

モデル公開後、GitHubでは短期間で多数のスターを獲得し、SNS上でも「Soraを超えた」との評価が相次いだ。VBenchベンチマークでは動画の動的表現において最高スコアを記録し、生成品質と滑らかさのバランスにおいて高評価を得ている。

本プロジェクトを支援したのは「今日資本」の徐新(Xu Xin)や、「創新工場」の李開復(Kai-Fu Lee)ら著名投資家。李氏はXで「世界クラスのオープンソース動画生成モデル」と称賛しており、今後の展開にも注目が集まっている。