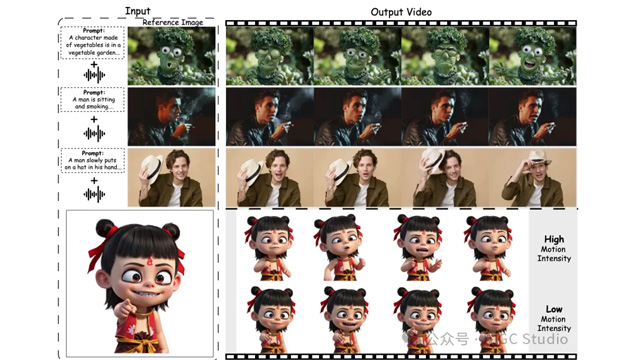

アリババ、高徳地図、北京郵電大学は、Wan2.1ベースの音声駆動型デジタルヒューマン技術「FantasyTalking」を共同発表した。画像、音声、テキストを入力するだけで、顔の特徴を保ちつつ、口の動きと全身のジェスチャーを自然に同期させた会話アニメーションが生成できる。

FantasyTalkingは、リアル調からアニメ調までの多様なスタイルに対応し、特写、半身、全身、正面・側面など様々な構図での表現が可能。唇の動きは音声とフレーム単位で精密に一致し、全身の動きも含めた視聴覚整合性が高いのが特徴だ。

技術的には、二段階の視聴覚アライメントを採用。第一段階では、肖像、背景、物体などを含む全体シーンに対して音声と動きの整合を取ることでグローバルな動きを制御し、第二段階では唇の動きをフレーム単位で最適化することで、音声との完全な同期を図っている。

さらに、顔中心のクロスアテンションモジュールによって、従来手法では難しかった映像全体における顔の一貫性保持を実現。また、表情と身体動作の強度をコントロールする「運動強度調整モジュール」により、動きの自然さと多様性も確保されている。

モデル性能は、マルチモーダル生成のSOTA手法であるOmniHuman-1と比較され、より高いリアリティ、一貫性、動作の豊かさ、個人特性の保持において優位性を示した。プロジェクトは既にオープンソースとしてGitHubにてコードが公開され、誰でも利用可能となっている。