バイトダンスのAIチームが、新たな画像生成モデル「UNO(Unified Neural Operator)」を発表した。FLUXモデルを基盤に開発されたUNOは、テキストからの画像生成(T2I)や複数の参考画像を組み合わせたマルチ主体画像生成まで、従来は分離されていたタスクを1つのモデルで統一的に処理する。

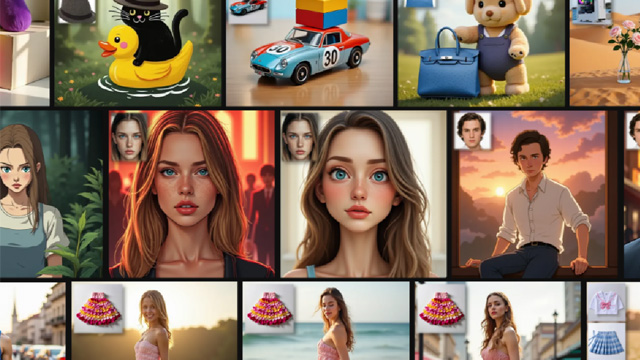

UNOの大きな特長は、1枚の画像内に複数の主体を自然に融合させる能力にある。最大4つの参考画像をもとに、対象の特徴を保ったまま異なるスタイルや構図で画像を生成することが可能で、例えばジブリ風の人物画の生成や、非生物体と人物の組み合わせといった複雑な構成にも対応できる。ユースケースとして、バーチャル試着や製品デザインなどが想定されている。

この柔軟な対応力は、「モデル-データ共同進化(co-evolution)」という訓練アプローチによって実現されている。初期は比較的弱いモデルで合成データを作成し、それをもとに段階的にモデル性能を強化する手法で、単一主体から多主体シナリオへの移行をスムーズに行う。モデル構造にはFLUX.1 devのマルチモーダル注意機構が活用されており、訓練は単主体から多主体へと2段階で進行する。

さらに、テキストと画像の位置関係を制御する新たな手法「UnoPE(通用旋转位置嵌入)」を導入。これは生成画像が参考画像の構図に依存しすぎる問題を抑制し、複数主体でも特徴が混乱しない安定した生成を可能にする。また、Object365に基づく365のトップカテゴリと細分類(年齢・職業・服装など)を用いて、LLMによって数百万規模のテキストプロンプトが自動生成される。

性能評価では、DreamBenchを用いた単主体・複数主体のタスクにおいて、DINOスコアやCLIP-I/CLIP-TスコアでいずれもSOTA(最先端)性能を記録。さらに、専門家と非専門家を含む30人による300画像の評価実験でも、UNOは主体の類似性・テキスト忠実度などあらゆる項目で高い評価を獲得した。

本プロジェクトは、バイトダンスのIntelligent Creationチームが主導しており、過去には画像生成モデルの美学向上を目的とした「VMix」なども手がけてきた。今回のUNOも同チームのFei Ding氏が責任者を務め、VmixやRealcustom++などの経験を活かした開発体制となっている。

現在、プロジェクト公式ページでは技術情報や生成例、構造の詳細が公開されており、論文では評価指標や実験設定についても詳しく説明されている。