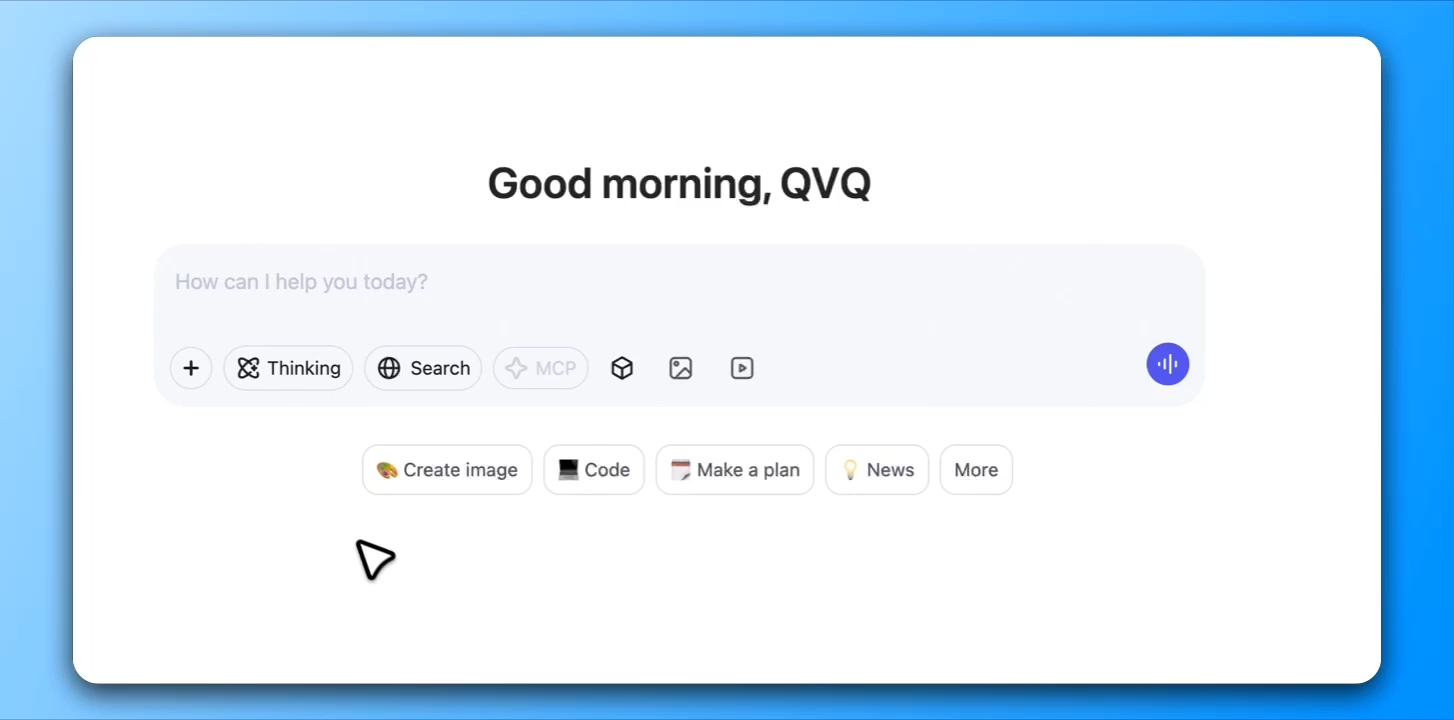

アリババの研究部門であるTongyi Lab(通義実験室)は、視覚推論に特化した最新AIモデル「QVQ-Max」の初版を正式に公開した。従来の生成系AIが主にテキストデータを入力として処理していたのに対し、QVQ-Maxは画像や動画といった視覚情報を解析し、そこから論理的な思考を展開する機能を持つ。視覚的な文脈を把握し、背景知識と照らし合わせて判断を下す“考える視覚AI”として位置づけられており、次世代のマルチモーダルAIの先駆けといえる存在だ。

QVQ-Maxが備える能力は大きく3つに分類される。まず第一に「詳細な観察力」。日常の写真から学術的なチャートまで、あらゆる画像を高精度に解析し、構成要素の識別やテキストの読み取り、空間関係の把握などを行うことができる。単なる物体認識にとどまらず、細部の違いや文脈に応じた注目点を抽出する力が強みとなっている。

第二に「深い推論力」。画像内の情報を読み取るだけでなく、それらの要素を相互に関連づけ、背景知識を活用して論理的な結論を導き出す。この機能は、例えば図形が含まれる数学問題において図と設問の関係を理解し、適切な解法を導くといった場面で威力を発揮する。また、動画からは場面の進行を予測することで、動的な文脈理解にも対応する。

第三に「柔軟な応用力」。QVQ-Maxは分析や推論だけでなく、創作活動にも適用可能な設計となっている。イラストの構図提案、スクリプトの草案生成、キャラクターに基づいた対話生成など、入力データに応じて多様なアウトプットを実現できる。たとえば、ユーザーが粗いスケッチをアップロードすれば、それをもとに完成度の高い作品へと昇華させる支援が可能だ。

実際の利用シーンは多岐にわたる。教育分野では、数式や図が含まれる物理・数学問題の解説、あるいは抽象的な概念の視覚化による理解促進が期待されている。ビジネス分野では、データビジュアライゼーションの自動解釈、レポート作成、UI設計補助などの業務支援に活用できる。日常生活では、ファッションコーディネートの提案、レシピ画像からの調理手順ガイド、家の間取り図からの家具配置アドバイスといった応用も想定されている。

現行バージョンは「初版(first iteration)」と位置づけられており、今後さらなる進化が予定されている。具体的には、視覚情報の正確性を高める「グラウンディング技術」の導入、複雑な操作手順を自律的にこなす「ビジュアルエージェント」化、テキストに加えて画像生成やツール操作まで含む「マルチモーダルな対話能力」の強化が挙げられている。将来的には、スマートフォンやPCのインターフェースを操作し、ゲームプレイなどにも対応できるAIとしての展開も視野に入る。

QVQ-Maxはまだ成長段階にあるとはいえ、その初版にしてすでに高い実用性と汎用性を示しており、視覚情報を基軸とするAIアシスタントの新たな可能性を切り拓く存在といえる。今後の継続的な最適化により、さまざまな実社会の課題解決に貢献する“見る・考えるAI”としての地位を確立していくことが期待される。