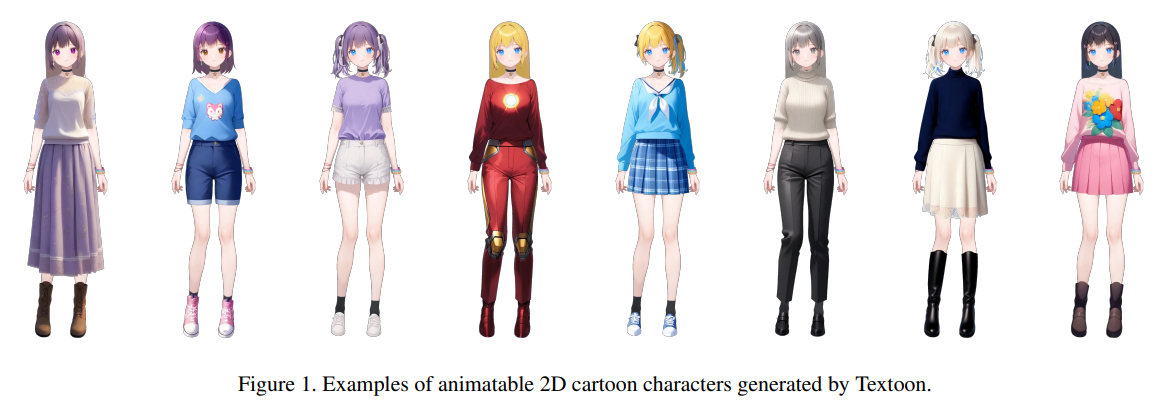

アリババグループ傘下のTongyi Labは2025年1月、ユーザーのテキスト入力に基づき高品質な2Dアニメキャラクターを自動生成する新技術「Textoon(テキストゥーン)」を発表した。これは、言語と視覚の高度なAIモデルを融合させた生成フレームワークで、入力された文章から髪型、目の色、服装、体型といった要素を抽出し、それらをLive2D形式で統合したインタラクティブなキャラクターに仕上げる。

Textoonは、細かいパーツ単位でのテキスト解析能力を持ち、ユーザーが入力した自由な記述をもとに、髪の長さや前髪、靴の種類に至るまで詳細な特徴を認識して外見を構築する。生成されたキャラクターはわずか1分以内で出力され、HTML5(H5)ベースでのシームレスな表示が可能なため、追加のソフトウェアを必要とせずにWeb上で即時に活用できる。

ユーザーは生成後のキャラクターに対して、特定パーツの変更・削除・追加といった再編集も可能で、インタラクティブ性の高い制作体験を実現している。また、アニメーション面では、ARKitのFace Blend Shape技術と連携することで、口の開閉や表情の変化といったリアルな動きをLive2D上で再現。従来の2Dキャラクターでは難しかった音声に合わせた口パクや表情表現も高い精度で実現できる点が大きな特徴だ。

Textoonは中国語・英語の両方に対応し、ゲーム開発、VTuber、デジタルアバター、教育ツールなど多様な領域での活用が見込まれる。アリババの公式サイトには多数の生成例が掲載されており、ユーザーは直感的なプロンプト設計で多彩なキャラクターを生み出すことができる。

【関連リンク】

論文(arXiv): https://arxiv.org/abs/2501.10020

公式サイト: https://human3daigc.github.io/Textoon_webpage

紹介動画: https://youtu.be/cA0yNZwyGTo