アリババグループの淘天Meta技術チームは、3DリアルタイムAIアバター「TaoAvatar」をオープンソースで公開した。最大の特徴は、スマートフォンやARデバイス上で完全にローカルかつオフラインで動作する点にある。音声認識(ASR)、音声合成(TTS)、音声から動作への変換(A2BS)、自然言語処理(LLM)、神経レンダリング(Neural Rendering)といった複数のAIモジュールを統合し、ネット接続不要で高精度な対話体験と3Dレンダリングを実現する。

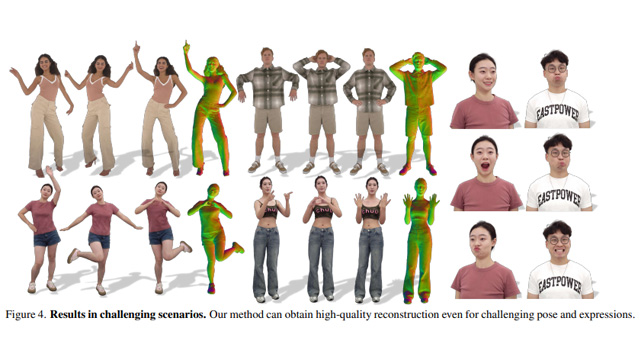

同アバターは、ユーザーの音声入力に対しリアルタイムで自然な表情・動作と音声応答を生成。従来の3DGS(3D Gaussian Splatting)ベース手法の課題だった「細部表現の欠如」や「モバイル実装の困難さ」を克服するため、論文では3段階のアーキテクチャを導入している。まず、個別に着衣・体型を反映したテンプレートを生成し、それを高精度に変形・補正するための教師モデル(StyleUnet)で学習。その後、蒸留により軽量なMLP(多層パーセプトロン)モデルへ圧縮し、さらに可変ガウス形状を加えることで高忠実度を維持したまま高速化を図った。

このアプローチにより、Apple Vision Proなどの高解像度ARデバイスにおいて90FPSの安定動作を実現。音声や手ぶり、表情などマルチモーダル信号に応じてアバターが応答する新世代の対話UIを提供する。

GitHub上では、Android向けにMNN(Mobile Neural Network)ベースのアプリ実装と導入手順が公開されており、Snapdragon 8 Gen 3やDimensity 9200クラスのSoC、8GB以上のRAM、5GBの空きストレージを推奨環境としている。インターフェースはPyTorchベースの学習済みモデルに対応し、MNN形式に変換して推論を実行可能。音声処理やレンダリング関連の設定も簡便で、一般ユーザーでも導入しやすい構成となっている。

今後、eコマース、教育、ホログラム通信、ゲーム、VTuberなど多分野での応用が期待されるTaoAvatarは、スマートフォンベースのAIエージェントやローカルLLMの実装トレンドとも接続し、モバイル端末による高機能AI体験のベンチマークとなり得る存在である。