中国の研究チームが発表した「OmniPart」は、画像と視覚マスクを入力とし、3Dアセットの“全体構造”と“部品構成”を同時に生成できる初のAIモデルとして注目を集めている。従来の3D生成手法は、全体形状の生成に特化しており、パーツごとの編集や再利用には不向きだった。OmniPartはこの課題を解消し、インタラクティブアプリケーションや生成AI(AIGC)に求められる編集性・解釈性を備えた生成を可能にしている。

本モデルの技術的特徴は、2段階の「デュアルエンジン構造」にある。第1段階では、自己回帰型構造プランナーが2Dセグメントマスクに基づき、可変長の3D部品バウンディングボックス列を生成する。これはパーツの粒度や配置を柔軟に制御でき、直感的な構成が可能。第2段階では、既存の大規模3D生成モデル(例えばGET3DやPoint-E)を再利用し、空間条件付きで各部品を整合性を保って同時生成する「条件付き整流生成モジュール」を採用する。

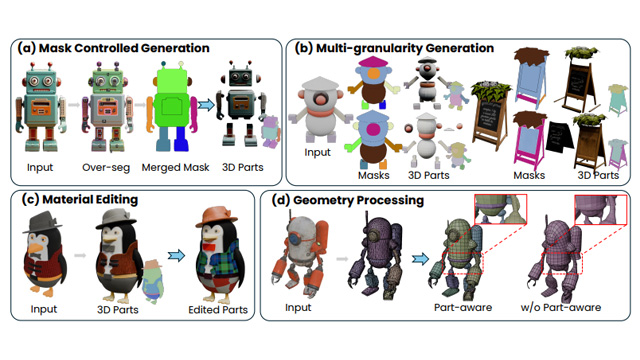

応用例も豊富だ。入力画像+セグメントマスクにより、高精度な3DメッシュやGaussian Splattingによる立体表現を出力可能。さらに、細粒度のマスク指定によるきめ細かいアセット構築、パーツごとの素材変更、幾何構造の再編集など、多岐にわたる用途に活用できる。公式Webサイトでは、サンプル画像のアップロードからマスク作成、3Dアセットの生成までをオンラインで体験可能なインターフェースも用意されている。

性能面では、ShapeNetやPartNetのベンチマークを用いた実験で、IoU(Intersection over Union)やChamfer距離などの複数指標において、従来のSOTAモデルを上回る結果を達成。特に、Semantic Decoupling(意味的非依存性)とStructural Cohesion(構造的一貫性)という2つの観点で優れた成果を示している。

OmniPartは、将来的に3Dコンテンツの民主化やインタラクティブUIの高度化、さらにはAI主導による設計支援ツールの基盤技術としても期待される存在である。