Zhipu(智譜)は7月2日、上海浦東で開催された産業生態大会にて、推論特化型の視覚言語モデル「GLM-4.1V-Thinking」を発表・公開した。10Bパラメータという小型モデルながら、Chain-of-Thought推論と課題別強化学習(RLCS)を組み合わせることで、多数のベンチマークで最高性能を記録した。

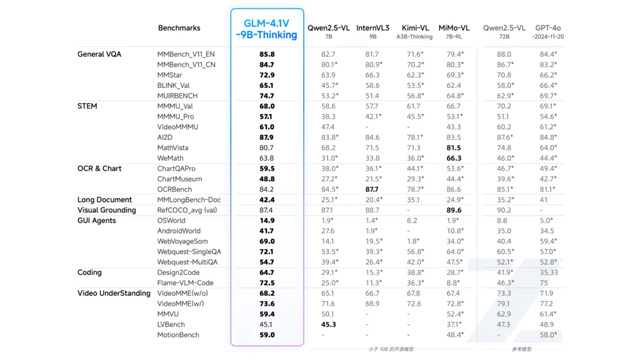

特にMMStarやMMMU-Proなど28項目中23項目で10B級モデルとして最高の評価を得ており、そのうち18項目では72B級のQwen-2.5-VLを超える精度を示した。画像・動画・文書・UIなど多モーダル入力に対応し、64Kコンテキスト長や4K画像処理も可能。

GLM-4.1V-ThinkingはGitHubとHugging FaceにてMITライセンスで公開されており、APIはZhipuの開発者プラットフォームで無償利用が可能。単GPU(RTX3090/A100)でも運用でき、LoRAなどによる学習や推論環境も整備されている。

また、ZhipuはMaaS型エージェント開発基盤「Agent応用空間」も同時にリリース。UI2CodeやGUI Agentなど実用的な業務向けアプリが開発でき、スタートアップ支援策「Agents開拓者計画」として数億元規模の資金提供も行われる。中国大手投資機関からの出資も発表されており、マルチモーダル×エージェントによるAI実用化が本格化している。